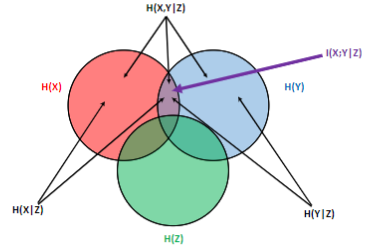

Information mutuelle conditionnelle

Quantité définie par : $$I(X;Y|Z)=\sum_{x\in\mathcal X}\sum_{y\in\mathcal Y}\sum_{z\in\mathcal Z}p_{XYZ}(x,y,z)\log_2\left(\frac{p_{XY|Z}(x,y|z) }{p_{X|Z}(x|z)p_{Y|Z}(y|z)}\right)$$

- correspond à l'information commune à \(X\) et \(Y\) lorsque \(Z\) est connu

- \(I(X;Y|Z)\geqslant\) \(0\), avec égalité si et seulement si \(X\to Z\to Y\) est une Chaîne de Markov

- on a les formules :

- \(I(X;Y|Z)=\) \(H(X|Z)+H(Y|Z)-H(X,Y|Z)\)

\(I(X;Y|Z)=\) \(H(X|Z)-H(X|Y,Z)=H(Y|Z)-H(Y|X,Z)\)

Questions de cours

START

Ω Basique (+inversé optionnel)

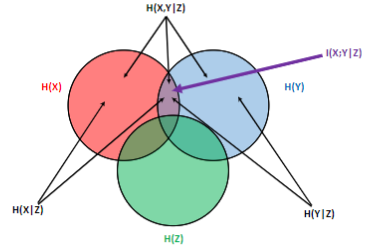

Recto: Comment représenter l'information mutuelle conditionnelle dans un diagramme de Venn ?

Verso:

Bonus:

Carte inversée ?:

END

START

Ω Basique (+inversé optionnel)

Recto: Explique pourquoi on ne peut pas toujours utiliser un diagramme de Venn pour justifier une majoration.

Verso: Le diagramme de Venn est trompeur, car il laisse penser que toutes les parties sont positives.

Or, rien ne justifie que le coeur du diagramme est positif (il ne correspond à aucune vraie valeur, donc pas d'

Inégalité de Gibbs ou quoi).

Bonus:

Carte inversée ?:

END

START

Ω Basique (+inversé optionnel)

Recto: Donner une caractérisation d'une chaîne de Markov \(X\to Y\to Z\).

Verso: $$I(X;Z|Y)=0$$

Bonus:

Carte inversée ?:

END

START

Ω Basique (+inversé optionnel)

Recto: Dans quel cas a-t-on \(I(X;Y|Z)=0\) ?

Verso: \(X\to Z\to Y\) doivent former une

Chaîne de Markov.

Bonus:

Carte inversée ?:

END

Exercices

START

Ω Basique (+inversé optionnel)

Recto: Que peut-on déduire des inégalités suivantes ? $$I(X;Y|Z)\lt I(X;Y)\quad\text{ et }\quad I(X;Y|Z)\gt I(X;Y).$$

Verso: Conditionner réduit l'entropie, mais a une action inconnue sur l'information mutuelle.

Bonus:

Carte inversée ?:

END